Quels risques pèsent sur la langue du fait des technologies ? Pourquoi s’alarmer de risques pesant sur la langue ? Comment pourrait-on compenser ces risques ? Y a-t-il un « bon » emploi des technologies ?

se rendre vers la Villette…

Du 7 au 9 janvier, s’est tenu à la Cité des Sciences de la Villette , un grand colloque « quel avenir pour les STIC ? », sous les auspices de l’ANR (« Agence Nationale de la Recherche », je rappelle ici qu’il s’agit de l’agence, créée en 2005, destinée à répartir les crédits de recherche des laboratoires sur la base de projets d’une durée limitée (3 ou 4 ans), je rappelle aussi que STIC est l’acronyme pour « Sciences et Technologies de l’Information et de la Communication », et que cela remplace ce qu’autrefois on appelait simplement « Informatique » - ce qui était d’ailleurs une jolie trouvaille terminologique). Evidemment, les questions posées ci-dessus n’étaient pas à l’ordre du jour d’un tel colloque, entièrement tourné vers la prospective « positive », autrement dit celle qui présuppose qu’on avance droit dans ses bottes et qu’il n’y a plus qu’à trouver de nouvelles « innovations », lesquelles bien entendu, auront un impact économique et permettront à la France de rebondir après la crise. On connaît le discours , un discours peu compatible avec des questions sur l’impact environnemental, surtout quand celui-ci ne vise pas ce qui est désormais admis sous ce terme (ressources physiques du globe, réchauffement climatique, pollution des éléments…), mais une forme d’environnement qui existe aussi : notre environnement « humain et culturel ».

Ces deux formes d’environnement sont-elles pourtant si opposées ? Il semble exister aujourd’hui un rapprochement toujours plus grand entre « nature » et « culture » (on en est à se demander par exemple si les grands singes n’ont pas eux aussi, une « culture ») qui pourrait nous amener à poser la question de la diversité des cultures (et des langues) dans les mêmes termes que celle des espèces biologiques. Or, dans ce colloque, la part destinée aux technologies du langage était très modeste (environ 10%) et, de plus, en général orientée vers une seule direction : la possibilité d’usage immédiat dans le secteur commercial (marketing, e-commerce etc.). Rien à voir avec ce que j’avais vu en Inde il y a quelques années (en 2003) en visitant un Centre « d’Indian Studies » dévolu à la préservation et à l’enseignement des multiples langues de ce pays (y compris les moins connues, parlées par les peuples dits « tribaux »).

(CIIL - Mysore)

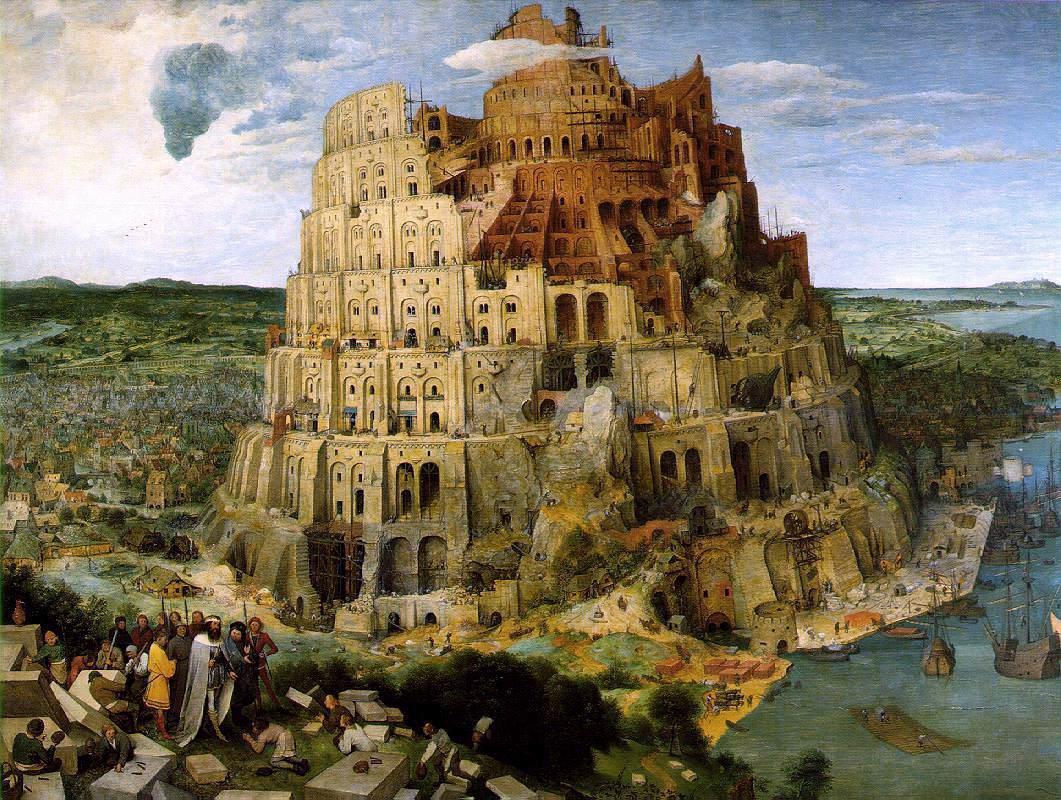

Les industriels sont intéressés principalement par des questions d’évaluation d’images au travers des mots, et aussi, il faut en convenir, avec la sempiternellequestion de la traduction automatique, vieux monstre qui hante nos fantasmes : faire enfin un jour que la différence des langues s’abolisse pour le grand bien de « la communication » (entendons en fait : de la globalisation). Comme toujours, lorsque la demande socio-économique est plus forte que ce que permettent nos connaissances, la science se mue en tours de magie. L’essentiel, c’est que « ça marche ». Ce qui devrait être un colloque scientifique devient une sorte de Concours Lépine évolué où le vendeur a bien du mal à vous expliquer pourquoi « ça marche »…

Ainsi de ce stand où un fringant et jeune chercheur bien sapé expliquait avec conviction qu’il avait, avec son labo, inventé un logiciel permettant de dresser un baromètre des opinions positives et négatives de personnalités rien qu’en analysant les textes diffusés sur les blogs. L’idée était de tenter d’étiqueter les phrases selon leur tonalité positive, ou négative. Ce n’est pas une mince affaire et notre vaillant technologue du langage montrait que si par exemple, vous avez une phrase comme « n’est-il pas intéressant que… », il pouvait s’y cacher une opinion positive alors même qu’elle se présente comme une négation. Certes. Le problème était qu’au résultat, il y avait toujours plus d’opinions positives que négatives…

Dans une présentation orale, cette fois, un autre chercheur exposait sa solution à la traduction automatique : solution, il est vrai, pratiquée par la plupart des spécialistes actuels et qui consiste à recourir massivement aux statistiques. Au lieu d’analyser les phrases (syntaxiquement, morphologiquement, lexicalement), ce qui s’avère une technique fort complexe et… fort chère, on stocke des masses de plus en plus grandes de corpus bilingues que l’on dit « alignés » : autrement dit, les phrases en deux langues différentes sont appariées. Cela permet ensuite lorsque vous entrez une phrase dans la langue L, d’obtenir une phrase correspondante en langue L’. L’algorithme consiste à rechercher la phrase la plus proche de celle qu’on a entrée. Si vous avez un immense corpus (à la limite, c’est l’ensemble de toutes les phrases d’une langue, corpus infini), vous pouvez obtenir parfois de bons résultats. L’ennuyeux est que d’éventuelles aspérités (augmentant la distance entre des phrases proches) sont gommées. Le traducteur de Google travaille comme cela : il n’est pas rare qu’une phrase entrée avec une négation (ne … pas) ressorte en anglais… sans la négation ! Ce qui, vous avouerez, est fâcheux.

Dans le cas de la présentation orale dont il est ici question, l’orateur était fier de montrer des traductions assez bonnes dans le domaine juridique. Elles avaient l’inconvénient de ne pas faire la différence entre les mots « inculpé » et « accusé ». Bah, disait notre chercheur, est-ce si important ? Et si dans le fond, on pouvait aboutir grâce à ces techniques à des lissages de vocabulaire. Toutes les distinctions entre les mots valent-elles la peine d’être gardées ?

Ce genre de réflexion fait bien sûr froid dans le dos, nous sommes presque dans la caricature… mais combien de « techniciens » du langage entretiennent ce rêve secret : parvenir finalement à simplifier la langue ? Faire en somme qu’il devienne bien plus facile de repérer les opinions positives ou négatives dans les discours parce que les scripteurs auraient accepté docilement de s’exprimer dans un « langage simple » ?

Tant que des langues sont libres, elles vivent et évoluent (et il est hors question dans ce blog d’adopter des attitudes puristes à la Finkielkraut qui sont des non-sens absolus), des distinctions de vocabulaire peuvent mourir, et avec elles des mots : on se console en pensant que sans arrêt des néologismes sont inventés. Le langage à l’état libre (et bien portant !) est un processus sans sujet et sans fin. L’asservir à des finalités hors langage (comme l’exploitation économique des techniques qu’il permet ou laisse entrevoir) c’est le lier, et à partir de là s’exposer à ce que son évolution n’aille que dans une seule direction : la disparition des mots, le lissage des vocabulaires.

Encore une raison, donc, de défendre la poésie.

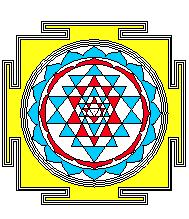

Noter cependant qu’il y a des outils technologiques que le défenseur des langues peut utiliser en tant qu’alliés. Est-ce un hasard si, la plupart du temps, ils sont basés sur des connaissances scientifiques authentiques ? Je pense à ces programmes savants mis au point par un informaticien ami (et membre de l’Académie des Sciences), dans le but de faciliter l’apprentissage de la morphologie du sanskrit . Mais qui s’intéresse au sanskrit, me direz-vous ?

(yantra produit par un programme en CaML écrit par G. Huet)

Eh bien, justement… c’est peut-être aussi le moment de s’y intéresser !